L’architecture événementielle s’est imposée comme un pilier fondamental dans le développement logiciel moderne, en particulier avec l’essor d’outils tels qu’Apache Kafka. Au cœur de cette révolution, une technique particulière : l’event sourcing. Ce concept non seulement change la manière dont les données sont manipulées, mais offre également une nouvelle perspective sur la gestion des états d’application. Dans cet article, nous explorerons comment l’event sourcing avec Kafka transforme les architectures de systèmes, promouvant une approche plus flexible, scalable et résiliente.

Qu’est-ce que l’Event Sourcing ?

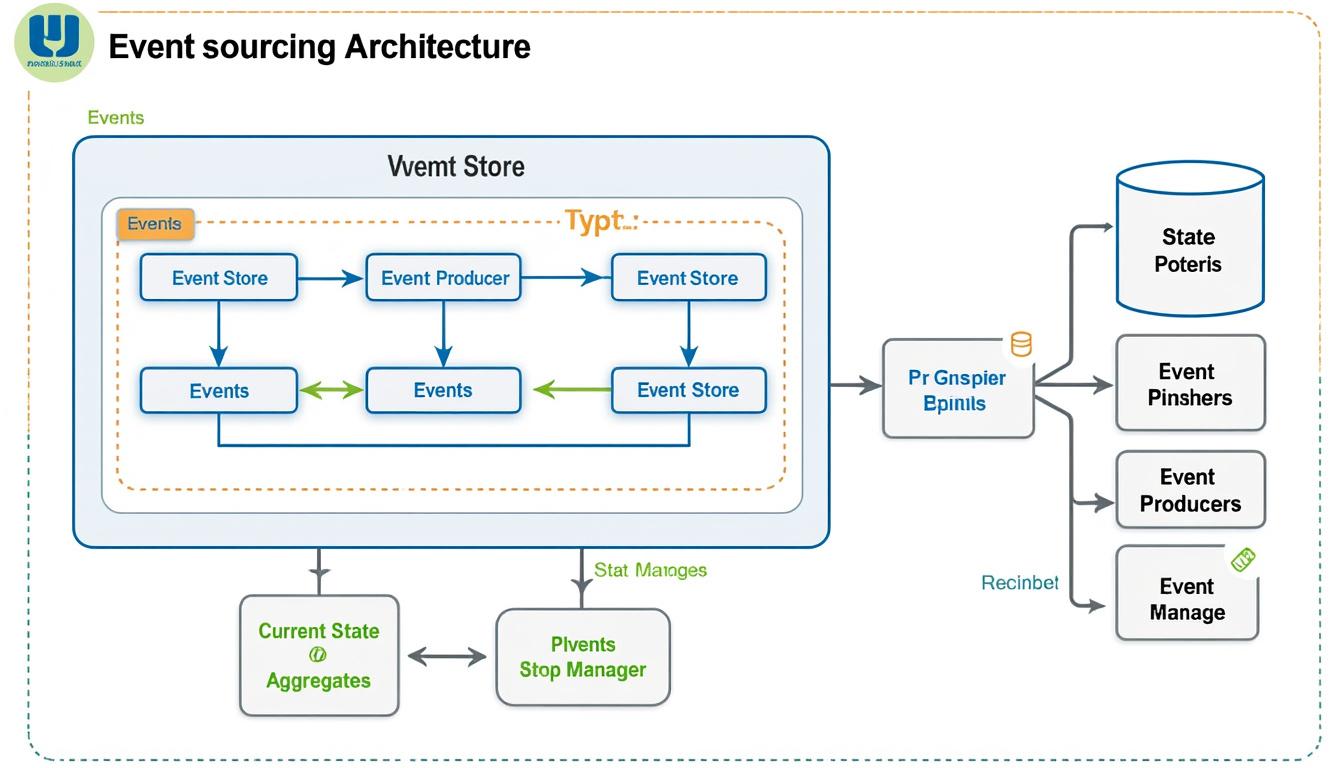

L’event sourcing est un modèle architectural qui repose sur la conservation d’une séquence d’événements au lieu de stocker l’état actuel d’une application. Ce modèle constitue une approche nouvelle et puissante pour construire des systèmes résilients.

Traditionnellement, dans une application, lorsqu’un utilisateur effectue une mise à jour, cette dernière change directement l’état de la base de données. Par exemple, si un utilisateur change son adresse e-mail, cette mise à jour remplace l’ancienne donnée dans la base de données. En revanche, avec l’event sourcing, chaque changement est enregistré en tant qu’événement distinct. Dans l’exemple de l’adresse e-mail, l’événement pourrait être intitulé « EmailChanged », et il décrirait la transition de l’ancienne adresse vers la nouvelle.

- Traceabilité : Chaque événement est immuable et peut être inspecté à tout moment, ce qui crée une journalisation parfaite des changements.

- Résilience : En cas de défaillance du système, il est possible de reconstruire l’état à partir des événements enregistrés.

- Analyse historique : L’historique complet des événements permet des analyses rétroactives approfondies.

Ces caractéristiques rendent l’event sourcing particulièrement prisé dans des systèmes complexes et dynamiques, où la gestion des états est cruciale. Toutefois, comme pour toute approche, des défis subsistent, notamment en matière de gestion de la performance et de la complexité du traitement des événements.

Avantages de l’Event Sourcing

Les bénéfices de l’utilisation de l’event sourcing sont multiples et touchent diverses dimensions des architectures logicielles.

| Avantage | Description |

|---|---|

| Reconstruire l’état | Permet de recréer n’importe quel état de l’application en rejouant les événements. |

| Facilite le débogage | Avec un historique d’événements, il est plus facile d’identifier la source des erreurs. |

| Interopérabilité | Les systèmes peuvent communiquer via des événements standardisés, facilitant l’intégration. |

Ces avantages positionnent l’event sourcing comme une solution attrayante pour de nombreuses applications modernes, particulièrement lorsque la flexibilité et la résilience sont primordiales.

Apache Kafka et l’Event Sourcing

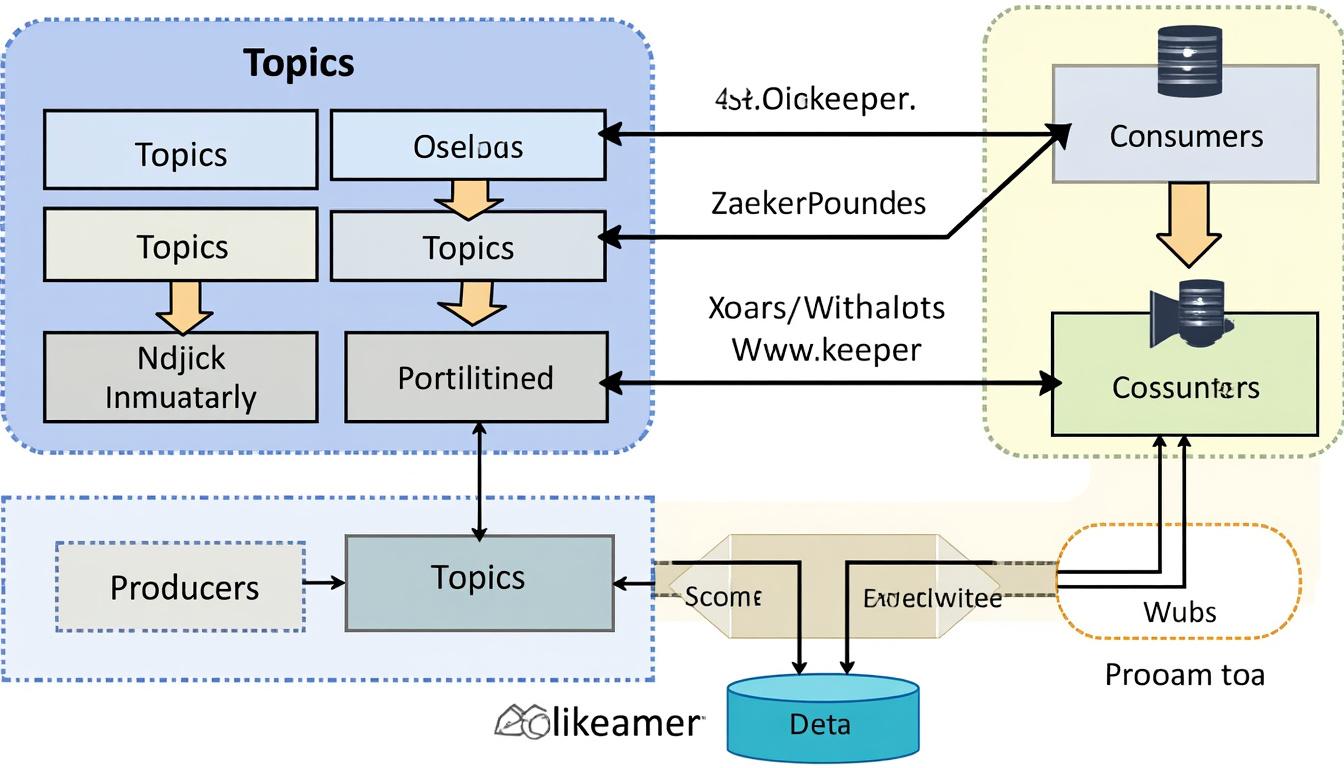

Apache Kafka, un système de messagerie distribué, est souvent associé à l’event sourcing en raison de sa capacité à ingérer et traiter de grands volumes d’événements en temps réel. Kafka agit comme un médiateur entre les producteurs d’événements et les consommateurs en assurant la distribution des messages de manière fiable.

Dans une architecture basée sur Kafka, chaque événement est enregistré dans un topic spécifique. Les producteurs, tels que des applications ou des services, publient des événements dans ces topics, tandis que les consommateurs peuvent être des services employés pour traiter ces événements.

- Scalabilité : Kafka peut gérer des millions d’événements par seconde, ce qui facilite l’évolution des applications au fur et à mesure de l’augmentation du volume de données.

- Durabilité : Les événements sont stockés de manière persistante, garantissant qu’aucune donnée ne sera perdue.

- Performance : Grâce à son architecture distribuée, Kafka offre des performances inégalées même sous forte charge.

En combinant l’event sourcing avec Apache Kafka, les entreprises peuvent créer des systèmes robustes capables de gérer des changements fréquents et massifs dans les données tout en maintenant l’intégrité de l’historique des événements.

Développer avec Kafka : Cas Pratiques

Pour illustrer comment l’event sourcing s’intègre dans une architecture Kafka, considérons quelques cas pratiques.

| Cas d’Utilisation | Description | Technologies Impliquées |

|---|---|---|

| Système de réservation | Enregistrement des réservations d’articles avec des événements tels que « Réservé », « Annulé ». | Kafka, eventuate |

| Gestion d’inventaire | Mise à jour des niveaux de stock avec des événements de changement de quantité. | Kafka, Debezium |

| Application bancaire | Transactions enregistrées sous forme d’événements avec événements tels que « Dépôt », « Retrait ». | Kafka, Axon Framework |

Chaque cas d’utilisation montre comment Kafka, en tant que plateforme de streaming, interagit avec l’event sourcing pour offrir des solutions adaptées aux exigences modernes des entreprises.

Outils et Frameworks Complémentaires

Au-delà d’Apache Kafka, plusieurs outils et frameworks peuvent enrichir l’expérience de développement d’applications basées sur l’event sourcing. Des solutions telles qu’EventStore, Apache Pulsar, et Spring Cloud Stream sont couramment utilisées dans cet écosystème.

Chaque outil apporte un ensemble spécifique de fonctionnalités qui peut améliorer la gestion des événements et faciliter leur intégration dans des architectures complexes.

- EventStore : Idéal pour le stockage d’événements avec des fonctionnalités d’indexation optimisées.

- Apache Pulsar : Propose une architecture multi-locataire et une résilience accrue.

- Spring Cloud Stream : Facilite le développement d’applications basées sur des événements en intégrant des abstractions simples autour de Kafka.

Intégration de Kafka avec d’autres technologies

Une intégration fluide entre Kafka et des systèmes existants ou des technologies tierces peut être réalisée grâce à des connecteurs tels que Debezium, qui permet de capturer les changements d’état dans des bases de données existantes.

| Connecteur | Fonctionnalité |

|---|---|

| Debezium | Capture les événements de changement de données à partir des bases de données. |

| Kafka Connect | Facilite la connexion de Kafka à des systèmes externes pour l’importation et l’exportation d’événements. |

Ces connecteurs jouent un rôle crucial dans l’architecture événementielle, garantissant que les données circulent de manière fluide et en temps réel.

Défis et Meilleures Pratiques

Bien que l’event sourcing et Kafka offrent de nombreux avantages, ils ne sont pas sans défis. L’un des principaux problèmes est la gestion de la complexité inhérente à ce type d’architecture.

Voici quelques pratiques recommandées pour surmonter ces défis :

- Modularité : Conception d’événements de manière modulaire pour réduire la complexité.

- Validation : Établir des règles de validation robustes pour les événements afin de garantir leur intégrité.

- Surveillance : Mettre en place des mesures de suivi et d’alerte afin d’identifier et de résoudre rapidement les problèmes.

En suivant ces pratiques, les équipes de développement peuvent créer des systèmes qui sont non seulement performants mais aussi faciles à maintenir.

Surveillance et Maintenance des Systèmes Événementiels

La surveillance des systèmes basés sur l’event sourcing est essentielle pour assurer leur bon fonctionnement. Des outils de monitoring comme Prometheus ou Grafana peuvent être utilisés pour obtenir des métriques en temps réel sur les événements, permettant aux équipes de réagir rapidement à toute anomalie.

| Élément | Importance |

|---|---|

| Logs d’événements | Source d’information cruciale pour le dépannage et l’analyse. |

| Alertes sur les anomalies | Pour identifier les problèmes avant qu’ils n’affectent les utilisateurs. |

Cela garantit que l’architecture événementielle évolue avec les besoins des entreprises et peut gérer avec succès la charge de travail croissante.

FAQ sur l’Event Sourcing et Kafka

Q : Qu’est-ce que l’event sourcing ?

A : L’event sourcing est une architecture qui enregistre tous les changements d’état d’une application sous forme d’événements immuables.

Q : Pourquoi utiliser Kafka pour l’event sourcing ?

A : Kafka permet de gérer et de traiter de grands volumes d’événements en temps réel, garantissant une distribution fiable et scalable.

Q : Quels outils complémentaires peuvent être utilisés avec Kafka ?

A : Des outils tels que Debezium pour la capture de données, ainsi que Spring Cloud Stream pour une intégration simplifiée, sont souvent utilisés.

Q : Quels sont les défis de l’event sourcing ?

A : La complexité de la gestion des événements et de leur ordre d’arrivée, ainsi que la nécessité d’un bon système de surveillance.

Q : Comment garantir la performance d’un système événementiel ?

A : En suivant les meilleures pratiques, comme la modularité et la mise en place d’alertes, tout en surveillant en continu les performances.